Xiaomiが2025年4月に発表した「MiMo-7B」は、同社初のオープンソース大規模言語モデル(LLM)であり、特に数学的推論やコード生成といった論理的推論タスクに特化しています。このモデルは、OpenAIの「o1-mini」やAlibabaの「Qwen-32B-Preview」など、より大規模なモデルと同等の性能を示しています。

🔍 MiMo-7Bの主な特徴

•パラメータ数:70億(7B)

•トレーニングデータ:約25兆トークンを使用し、3段階のデータミックス戦略を採用

•強化学習(RL):13万件の数学およびコード問題を用いてトレーニング

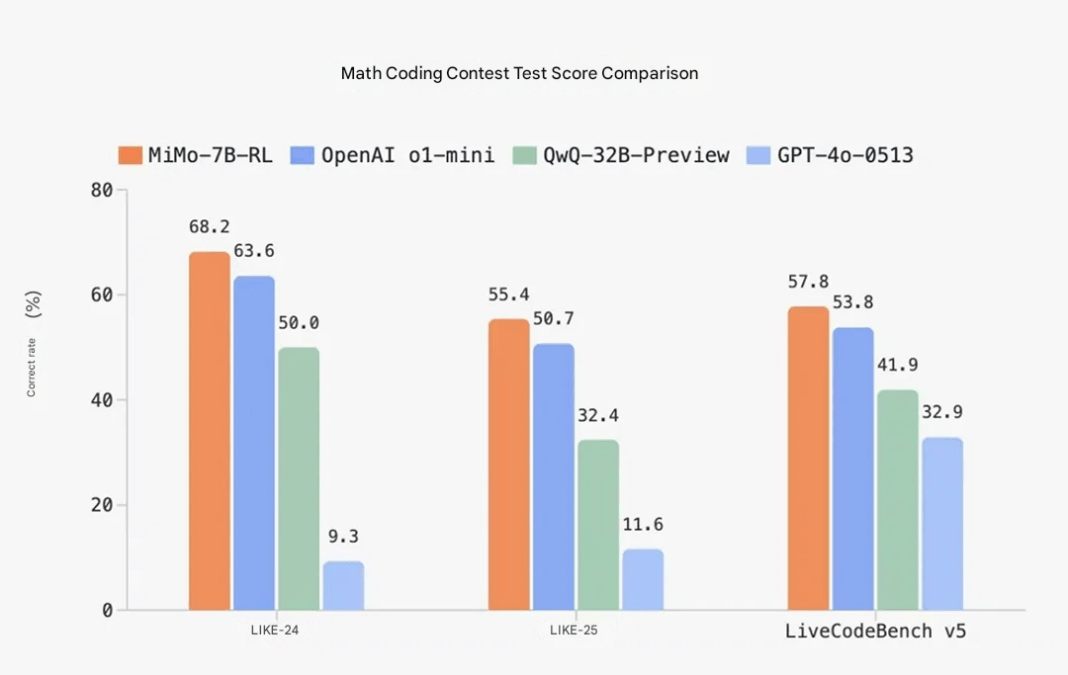

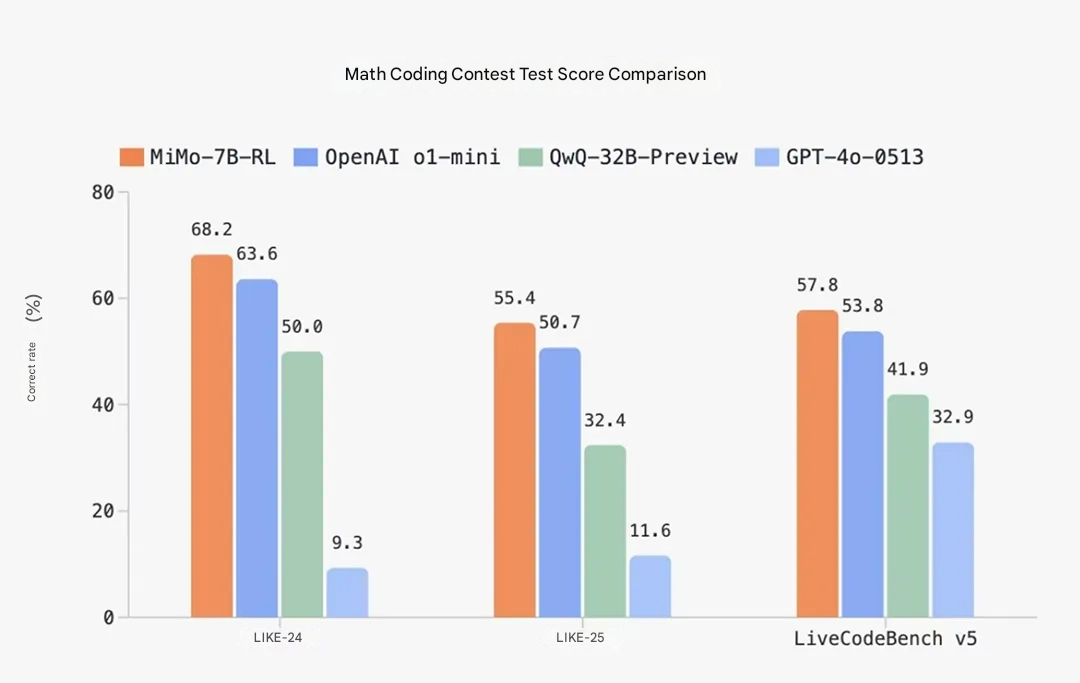

•性能:数学ベンチマーク「AIME 2025」では55.4%の正答率、コード生成ベンチマーク「LiveCodeBench v5」では57.8%のスコアを記録

•モデルバリエーション:MiMo-7B-Base、MiMo-7B-SFT、MiMo-7B-RL-Zero、MiMo-7B-RLなどがあり、Hugging Faceで公開されています

🧠 技術的な革新点

•Multiple-Token Prediction(MTP):推論性能の向上と生成速度の高速化を実現

•テスト難易度駆動型報酬(Test Difficulty Driven Reward):複雑なコード生成タスクにおける報酬のスパース性を解消

•データ再サンプリング戦略:容易な問題のトレーニングデータを調整し、強化学習の安定性を向上

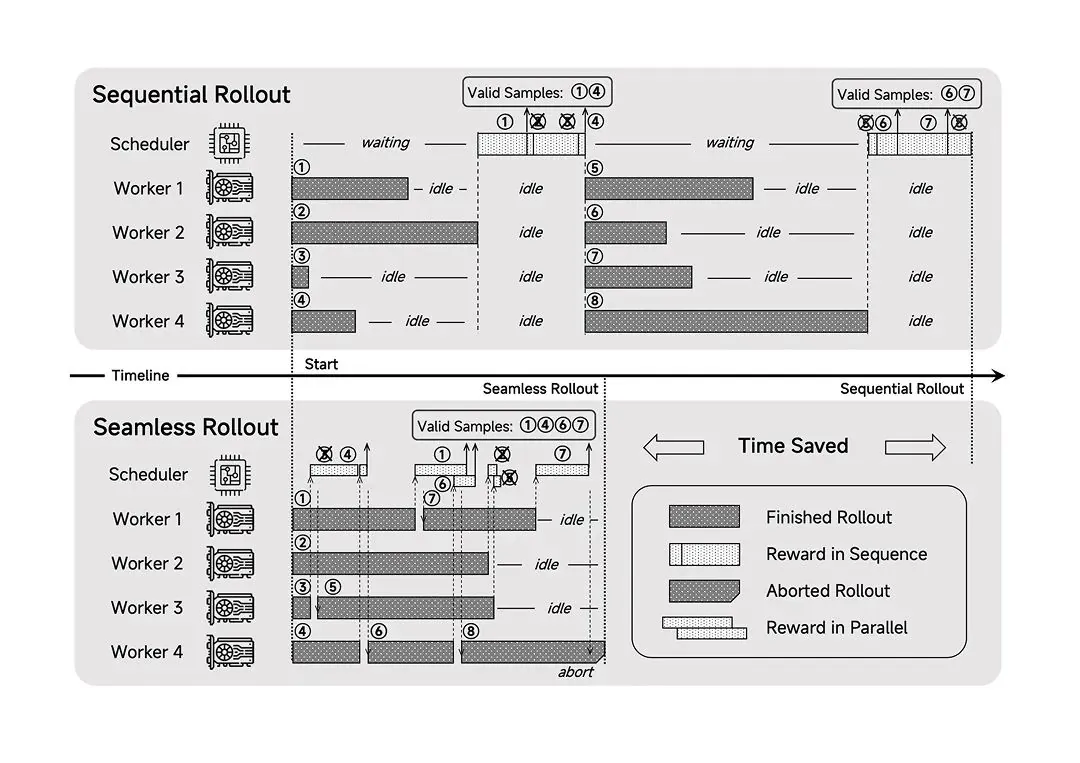

•Seamless Rollout Engine:GPUのアイドル時間を最小限に抑え、トレーニングと検証の速度をそれぞれ2.29倍、1.96倍に高速化

📥 モデルの入手方法

MiMo-7Bシリーズのモデルは、以下のリンクから入手可能です:

•Hugging Face: XiaomiMiMo/MiMo-7B-RL

•GitHub:XiaomiMiMo/MiMo

MiMo-7Bは、XiaomiのAI戦略における重要なステップであり、同社の「AI+IoT」戦略の基盤として、スマートフォンや家電、自動車など多様な製品への応用が期待されています。今後の展開に注目が集まります。